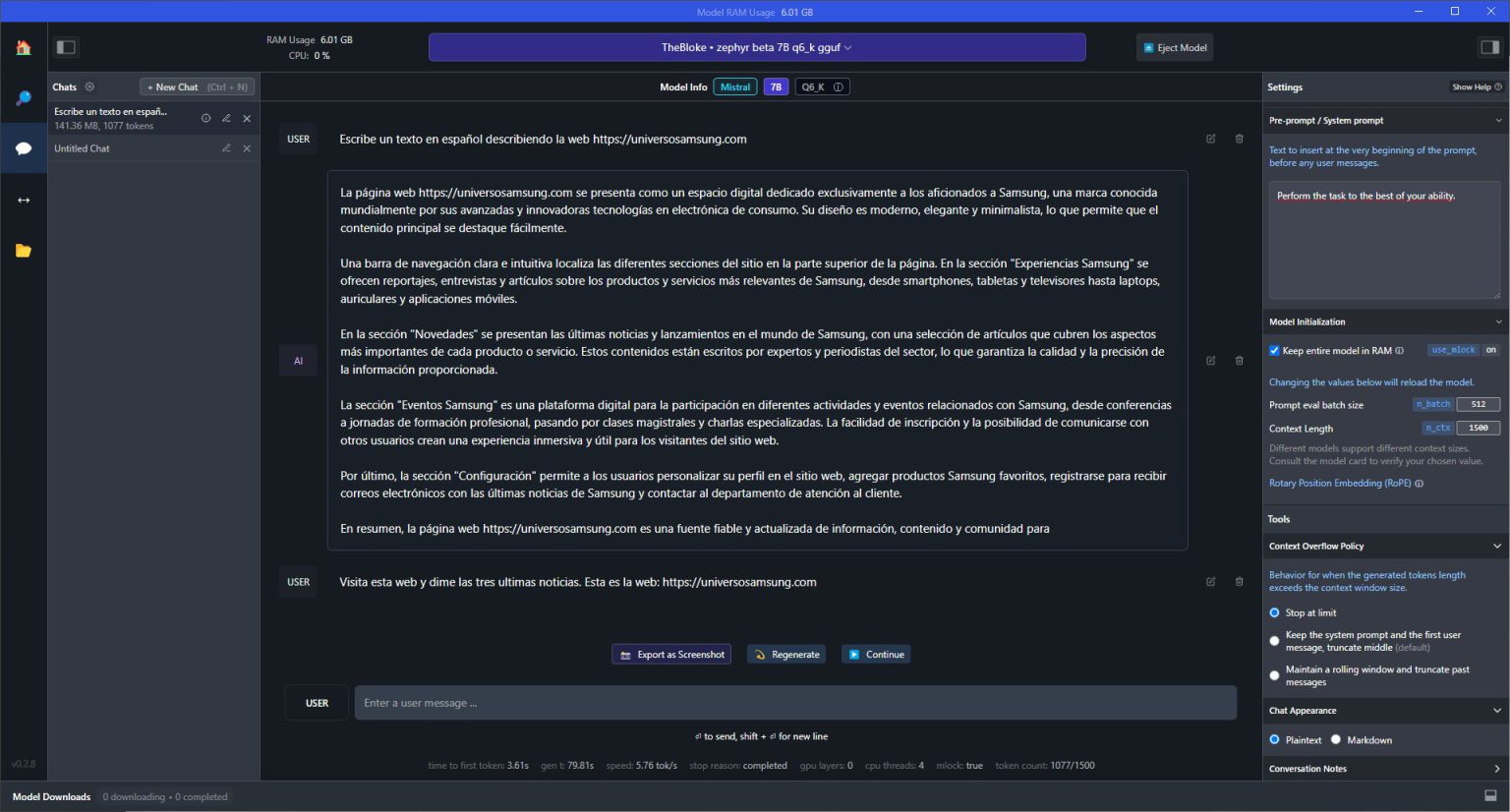

He estado probando LM Studio, una aplicación para Windows, Linux y Mac que te permite usar modelos de inteligencia artificial en tu PC sin compartir los datos con terceros.

En España, estamos celebrando aún el puente de La Constitución, y este pequeño tiempo me ha dado lo suficiente como para poder probar algunos juguetes tecnológicos nuevos. Me gusta mucho investigar y probar cosas nuevas, y la falta de tiempo y el trabajo son dos limitantes que me afectan para poder jugar a gusto con este tipo de “inventos”.

El caso es que gracias a una publicación de XDA Developers he descubierto LM Studio, una aplicación para poder ejecutar modelos de Inteligencia artificial basados en lenguaje (LLM) en un PC o portátil de casa. Hay una versión para Mac también y puedes solicitar otra para Linux en el Discord oficial de la compañía. Además de la flexibilidad y ahorro de costes que ofrece esta aplicación, la principal baza es que algunos determinados lenguajes pueden leer enlaces si tienes conexión a Internet.

Antes de empezar, requisitos mínimos y consejos básicos

Se trata de una aplicación completamente gratuita y que te da a elegir entre un enorme catálogo de grandes modelos de lenguaje avanzados. La idea es bastante básica y sorprende que no se haya hecho algo así antes, y si ya existía, yo al menos no he probado nada con tan buenos resultados y que funcione tan bien. Así que déjame contarte mi experiencia de manera breve.

Antes de empezar a usarlo, debes tener en cuenta que necesitarás al menos un buen procesador y, especialmente RAM, mucha RAM. Porque estos modelos de lenguaje natural consumen bastante memoria en cada consulta, así que no te servirá cualquier equipo. Si tienes una buena gráfica, también te ayudará a reducir la carga. En ningún caso esperes la velocidad de procesamiento de ChatGPT. En mi caso ha sido sencillo porque cuento con un portátil más que bien equipado con 32GB una Nvidia 3070Ti y un Rizen 5000 Series. Pero si quieres saber cuáles son los requisitos mínimos para que puedas echarlo a andar.

- Apple Silicon Mac (M1/M2/M3) con macOS 13.6 o superior.

- Para Windows o Linux, un procesador que soporte AVX2.

- Más de 16GB de RAM es lo ideal.

- Más de 6GB de VRAM.

- GPU NVIDIA o AMD.

Mis primeros pasos con LM Studio

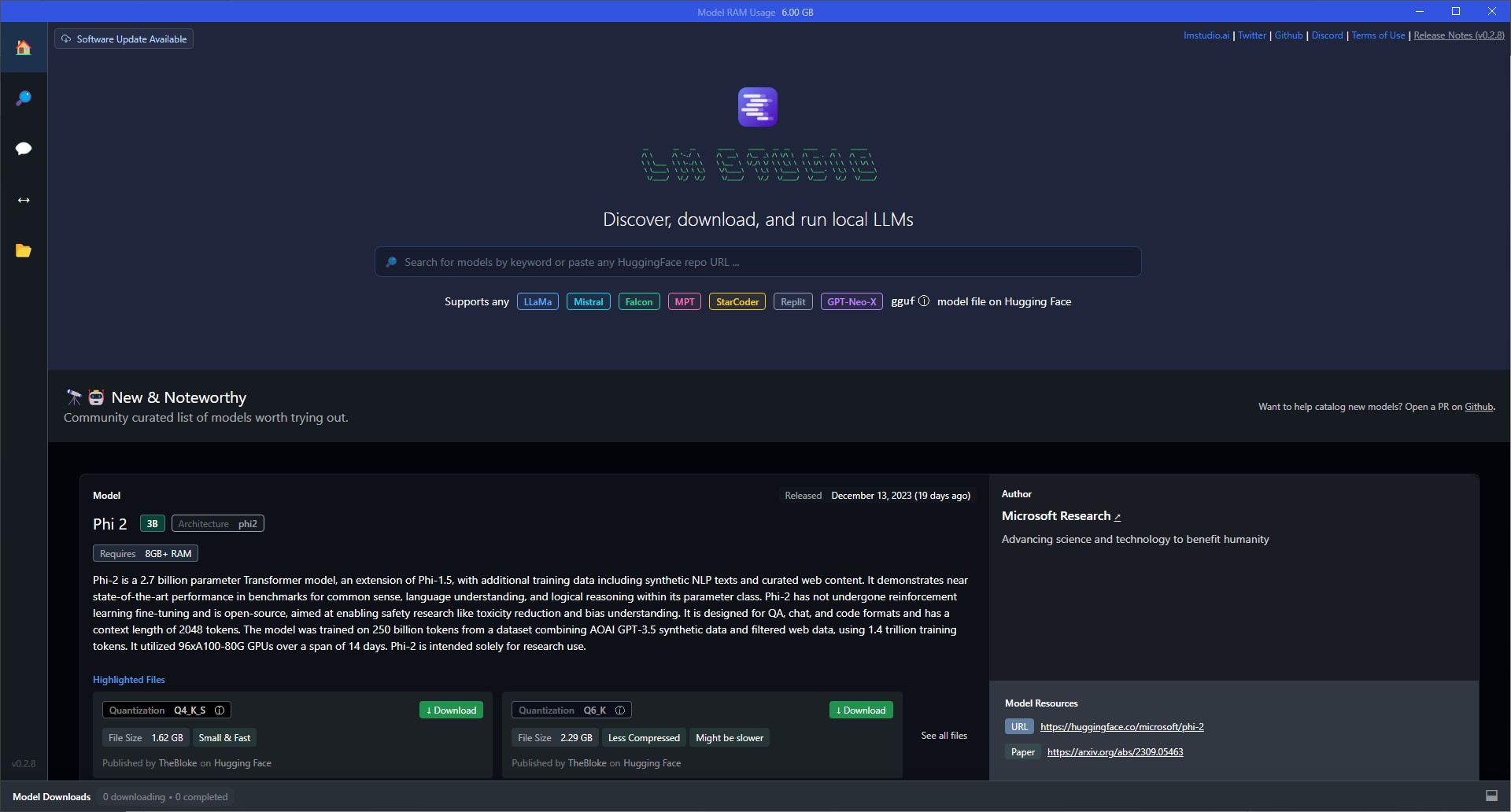

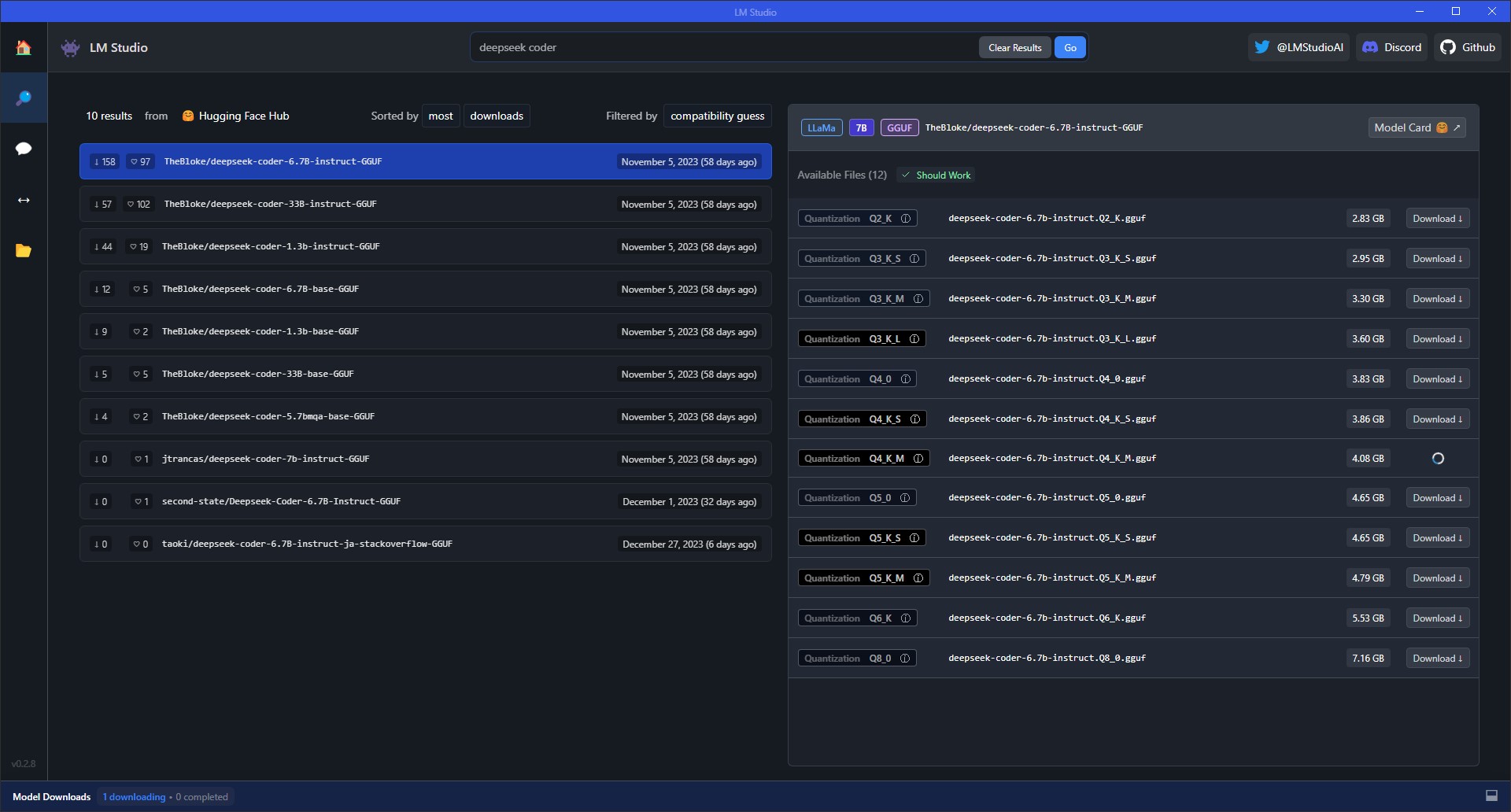

El uso de esta herramienta es sencillo, solo tienes que descargarte el LLM que quieres utilizar y empezar a probarlo. Tienes un enorme abanico disponible, y la propia herramienta te va diciendo los requisitos de RAM que necesita tu equipo para poder mover un lenguaje determinado. La interfaz es muy sencilla, por un lado tienes la portada, que te deja un listado de los últimos LLM agregados, el desglose de lo que hace cada uno y la RAM necesaria para moverlo. Si no te quieres perder entre tantas opciones, puedes usar el buscador y buscar uno para ir jugando con él.

Yo te recomiendo cualquier variante de Zephir, que requiere solo 8GB de RAM y entiende bien el español. Aunque tienes un montón de lenguajes más para ir jugando. Una vez que te hayas descargado uno o varios, solo tienes que irte al icono de un mensaje, cargar el lenguaje que quieras usar, y empezar a escribir el prompt que quieras.

Opciones y presets

Una de las cosas que más me han gustado es que LM Studio te permite generar un prompt predefinido donde ya le des instrucciones o le digas que se comporte con determinado rol específico, por ejemplo un experto en tecnología. Entre las opciones que hay disponibles, estas son algunas de las más destacadas, ten en cuenta que estos ajustes se llevan a cabo en la parte de chat:

- Elige el rol que quieras para el prompt.

- Preconfigura una instrucción inicial, por ejemplo: “Responde siempre en español” y se inyectará en el prompt.

- Puedes elegir el número de palabras que quieres que te saque, limitar los tokens y más.

- Guardar múltiples presets y cargarlos o exportalos en un JSON.

- Elegir si quieres que te responda en texto plano o en markdown, esto último es ideal si trabajas con código.

- Añadir notas en un chat.

Por último, pero no menos importante, puedes crear un “Servidor de Inferencia Local” que imita el comportamiento de la API de Completado de Chat de OpenAI, pero se ejecuta localmente en tu máquina. Este es un servidor que se ejecuta en tu máquina y realiza operaciones de inferencia localmente. La inferencia en este contexto se refiere al proceso de predecir o completar resultados basados en un modelo entrenado, en este caso, el modelo de Completado de Chat de OpenAI.

Mi experiencia final con LM Studio

Actualmente, mientras redacto estas líneas, estoy usando la versión beta v0.2.8 de la aplicación, y lo cierto es que hay algunos lenguajes que me resuelven muchas papeletas. Si tienes un equipo solvente, es quizá la mejor opción que puedes tener para trabajar con código, textos y otro tipo de gestiones más específicas sin necesidad de exponer tus datos a un tercero como OpenAI.

Eso sí, ten en cuenta que de momento no puedes entrenar modelos, todos los que te descargues ya vendrán entrenados. De todas formas tienes LLMs de todo tipo, por ejemplo xDAN, Microsoft Phi2-2 o las variantes de AdaptLLM para medicina, finanzas o biomedicina.

Así que en líneas generales me parece algo muy necesario tanto para profesionales como para particulares que no quieran automatizar aplicaciones, sencillamente usar una interfaz y dar órdenes a un sistema de inteligencia artificial especializado.

Puedes descargar la última versión desde este enlace, y si quieres filtrar y buscar modelos, te recomiendo ir a Huggin Face.